3D Visualisierung des Untergrunds, Foto: Schlumberger

Flächen unter der Oberfläche

Geologen und die Erdölindustrie wollten immer schon wissen, wie das Erdinnere aussieht. Mittels computergenerierter Bilder lässt sich genauer verstehen, wie die Subsurfaces genannten Oberflächen unter der Oberfläche aussehen.

Text — Christoph Engemann — 15.12.2021

Abbildungen — Archive

Es ist ein schwarzer Stoff, der die teuersten Bilder der Erde hervorbringt. Öl liegt dort wo kein Licht es erreichen kann, tief im Erdinneren in porösen Gesteinsschichten versteckt. Seit Öl Anfang des 20. Jahrhunderts Kohle als primären fossilen Energieträger abgelöst hat und damit den Übergang zur von der amerikanischen Kulturwissenschaftlerin Stephanie LeMenager «Petromoderne»[1] genannten historischen Etappe vollzogen wurde, ist die Frage, wie man den Untergrund sichtbar machen kann, eine der drängendsten der Energiewirtschaft.

Um Öl zu fördern, müssen Bohrtürme aufgestellt werden und die Auswahl der richtigen Stelle entscheidet darüber, ob die damit einhergehenden Investitionen sich auszahlen. Bereits in den 1950er-Jahren lagen die Kosten einer Bohrung bei gut einer Million US-Dollar. Heute liegen die Aufwendungen bei 20 bis 30 Millionen Dollar und entsprechend hoch ist der Druck, bei einer Bohrung auf Öl stoßen zu müssen.

Das Finden einer geeigneten Stelle blieb bis in die 1920er-Jahre eine arkane Angelegenheit. Die mit dieser Aufgabe betrauten Geologen überließen es oft ihrer sprichwörtlichen Nase, einen Standort auszuwählen.

Die berühmte Ölstadt Burkburnett, Texas. Unter der Oberfläche befindet sich eines der reichsten Ölvorkommen der Welt. Alle Ölbohrtürme sind in Betrieb, 1920. Foto: Underwood & Underwood/Library of Congress Prints and Photographs Division Washington, D.C. 20540 USA, LOT 8806

Seismische Verfahren wurden im Ersten Weltkrieg entwickelt

Erst seismische Verfahren, die im Ersten Weltkrieg zur Lokalisation feindlicher Artillerie verfeinert worden waren, erlaubten es, den Untergrund zu kartieren. Die mittels Sprengungen oder mechanisch erzeugter Erschütterungen in den Untergrund geschickten Schallwellen werden an den Grenzflächen der unterirdischen Schichten unterschiedlich stark reflektiert. Oberirdisch entstehen so seismografische Messkurven, die Gesteinsschichten im Querschnitt sichtbar machen. Jede der Linien stellt einen Übergang oder eine Verwerfung zwischen historisch über Millionen von Jahren entstandenen Schichten dar. Die im seismischen Messschrieb abgebildeten Schichten sind quasi ehemalige Oberflächen, die einmal Licht kannten und jetzt zugedeckt von über ihr gewachsenen Schichten im Erdunkeln liegen.

Im Englischen verweist der Begriff Subsurfaces in seiner Doppeldeutigkeit von unter der Oberfläche und Unteroberflächen auf diesen merkwürdigen Umstand von Oberflächen unter der Oberfläche.

Sichtbar und zu Flächen gemacht werden diese lichtlosen Oberflächen inzwischen mit Computern. In der prädigitalen Seismik wurden Seismogramme mit Linienschreibern auf mit Endlospapier bespannten Meßtrommeln angefertigt.

Sie stellten den Untergrund im Querschnitt dar, wobei einzelne Linien Reflektionen einzelner Schichten entsprachen. Es blieb der Imagination der auswertenden Geologen und Geophysiker überlassen, aus diesen Linien Lagerstätten zu interpretieren. Dabei blieb die Beurteilung der Linienverläufe mit großen Unsicherheiten behaftet und die Domäne erfahrener Geologen. Es ist die Erdölindustrie, die die Systematisierung und Verwissenschaftlichung der Seismologie maßgeblich vorantreibt. Während des Zweiten Weltkriegs, der ungeheure Mengen von Erdöl verschlang und mit einer petrochemische Revolution künstliche Produkte wie Polyester hervorbrachte [2], waren seismische Vermessungstrupps hinter allen Fronten aktiv und kartierten den Untergrund.

Linien-Seismogramm: Der deutsche Geophysiker Ludger Mintrop hat als erster das damals neue Verfahren der Refraktionsseismik erfolgreich bei der Ölsuche angewendet. Die beiden Risszeichnungen mit dem Apparat und darunter der seismischen Aufzeichnung, stammen aus der amerikanischen Patenschrift von 1926, Quelle: DGG Mitteilungen 1/2006 S. 8

Im Englischen verweist der Begriff Subsurfaces in seiner Doppeldeutigkeit von unter der Oberfläche und Unteroberflächen auf diesen merkwürdigen Umstand von Oberflächen unter der Oberfläche.

Die Erdölindustrie war maßgeblich an der Entwicklung von Computern beteiligt

Sehr früh in der Geschichte der digitalen Computer, die in den letzten zwei Jahren des Zweiten Weltkriegs erstmals zum Laufen kamen, wurde die Ölexplorationsindustrie zu einer der frühsten kommerziellen Nutzerinnen dieser Technologie. Bereits 1952 betrieb die französisch-amerikanische Firma Schlumberger eine Computeranlage zur Auswertung von seismischen Messungen.

Innerhalb weniger Jahre entwickelte sich die Erdöindustrie neben dem Flugzeugbau zu einem Wirtschaftszweig, der schon um 1960 Computersimulationen zu einer wichtigen Geschäftsgrundlage wurde.

Für die Entscheidung, wo ein Bohrturm stehen sollte, wurden nun Reservoirsimulationen genutzt, die für ein Ölfeld den wahrscheinlich zu erwartenden Druck an einer bestimmten Bohrstelle vorhersagen sollten. Die Karten dieser Reservoirsimulationen waren aber noch zweidimensional und zeigten auf einem Raster die unterschiedlichen Druckverhältnisse, die oberirdisch erwartet wurden. Der Blick in die Erde, zu den Subsurfaces blieb der Vorstellungskraft der Geologen vorbehalten.

Früher hatte die dritte Dimension viel mit der Imaginationskraft der Geologen zu tun

Der entscheidende Schritt, der es erlaubte, aus zweidimensionalen Linienseismogrammen dreidimensionale Abbildungen der Strukturen des Untergrunds zu machen, wurde Ende der 1960er-Jahre vollzogen. Das erste erfolgreiche Verfahren einer solchen Verräumlichung des Untergrunds kam noch ohne Computer aus und wurde vom bei der amerikanischen Firma Esso angestellten Geologen George G. Walton 1970 dem staunenden Publikum der Jahrestagung der Society of Explorative Scientist vorgestellt.

Walton schrieb in seinem etwas später veröffentlichten Text «Three-Dimensional Seismic Method», dass die dritte Dimension in seismischen Daten bislang aus dem Gedächtnis und der Imagination der Geologen gestammt habe. Mit seinem neuen Verfahren wurde die dritte Dimension medientechnisch erzeugt.

Es handelte sich um eine clevere Anordnung, bei der die Linienseismogramme von 48 seismischen Messstationen auf einem analogen Film dergestalt überlagert wurden, dass bei der Projektion des Films die seismischen Wellenfronten auf einen Bildschirm sichtbar wurden. Der laufende Film ließ gleichsam wie ein Auge vertikal durch die Tiefe fahren und zeigte im Umkreis von etwa einer Meile die Abschichtungen der Gesteinsformationen. Das durch den Film auf einen Bildschirm fallende Projektionslicht ließ die Geologen das erste Mal in der Geschichte längst versunkene Erdoberflächen erscheinen, die oft seit Millionen Jahren kein Licht mehr beschienen hatte.

Ohne Bildschirme gibt es keine Subsurfaces. Sie sind Artefakte einer medientechnischen Infrastruktur, die zugleich global den Planeten mit seismischen Messkampagnen überzogen hat, wie auch Resultat einer komplexen und noch weitgehend unbeschriebenen Evolution seismischer Bildgenerierung.

Die Rechenkraft der Computer determiniert die Dichte der Messsondennetze

Das filmbasierte analoge Verfahren Waltons wurde innerhalb kurzer Zeit unter Anwendung von Algorithmen aus der gerade erst entstehenden Computergrafik durch computergenerierte Bilder abgelöst. Beruhte Waltons Methode noch auf 48 Messstationen, konnten jetzt die Daten von Hunderten gitterförmig ausgelegten Messsonden im Computer integriert und in eine perspektivische Darstellung überführt werden.

In der Petroindustrie ist dabei von «imaging technique» die Rede. In diesem Begriff zeigt sich, dass hier keine Fotoaufnahme gemacht wird, sondern Bilder aufwendig konstruiert werden müssen. Bis heute werden diese «imaging techinques» atemlos verfeinert und optimiert.

Es ist die Rechenkraft der Computer, die die Dichte der Messsondennetze determiniert. Die Auflösung der im Untergrund sichtbaren Strukturen kann mit einer größeren Anzahl von Messsonden gesteigert werden, so genügend Prozessorkapazität verfügbar ist. Bis heute ist dieser Zusammenhang ungebrochen.

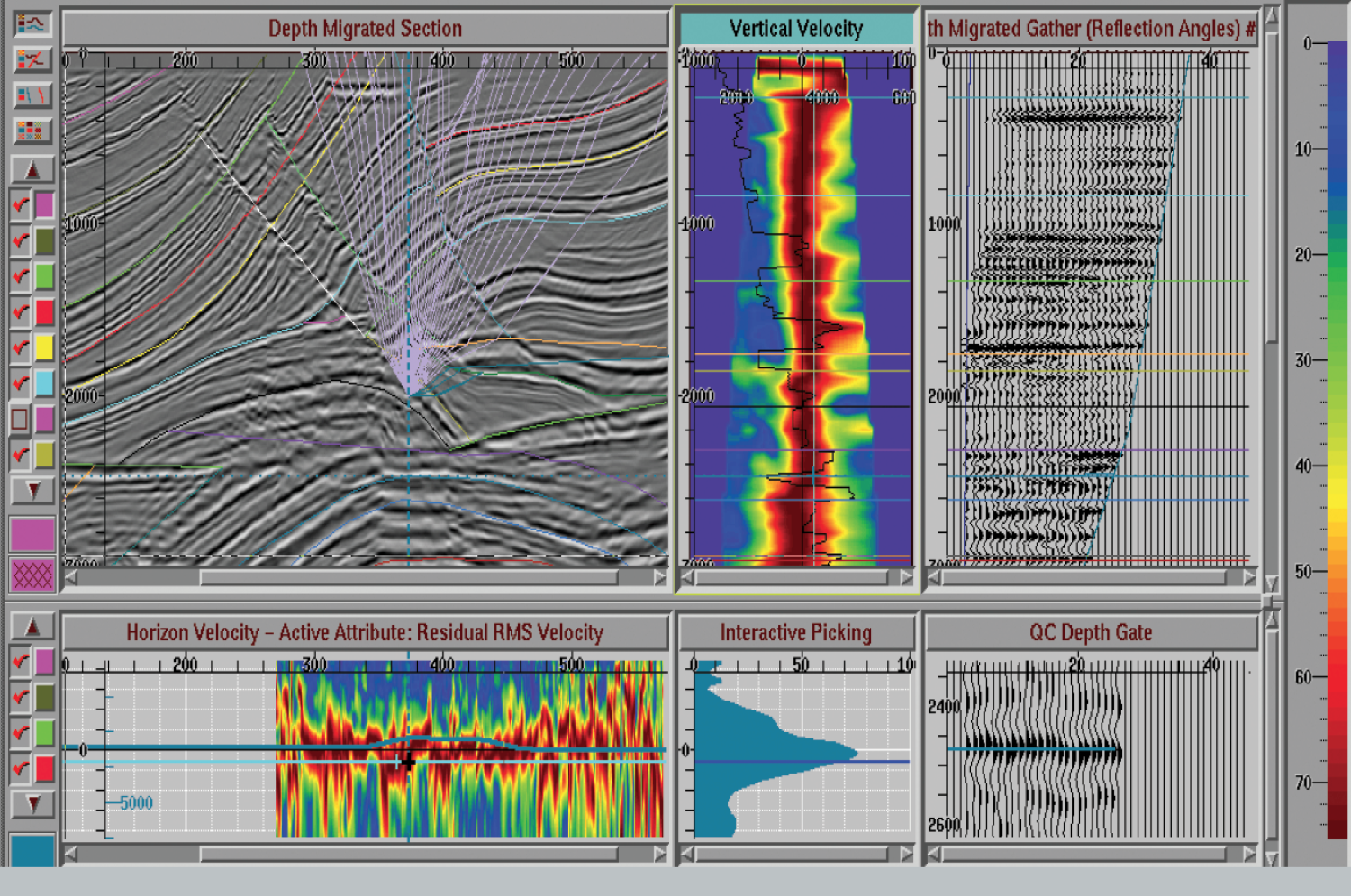

Seismische Erkundung durch Erfassen von Daten: indirekte Messungen über Gesteinen beleuchten den Untergrund. Mit Bildern, Interpretationen und geologischen Modellen lässt sich der Aufbau des Untergrunds verstehen. Ein Rechner braucht tage- und wochenlang, bevor aus den Daten Bilder werden. Ein kleiner Auftrag nutzt Hunderte von Rechenknoten für mehrere Tage (100K Core-Stunden), ein großer Job nutzt Tausende von Rechenknoten für ein bis zwei Wochen (3-5M Core-Stunden), aus: Wyatt Gorman (Google), Abhishek Gupta (Schlumberger): Get Your Head in the Cloud: Lessons in GPU Computing with Schlumberger (Presented by Google Cloud) 2019, S. 37

Das extrem spezialisierte Personal, das diese Computeranlagen bedienen kann, ist teuer

Es werden immer schnellere Computeranlagen benötigt, um immer genauere Bilder der subsurfaces zu erzeugen. Die Ölindustrie betreibt dazu mit die größten Supercomputer der Welt mit inzwischen in die Millionen gehenden Prozessoren. Der Strom- und Kühlungsbedarf solcher Anlagen verschlingt bereits mehrere Millionen Dollar jährlich, die Anschaffungskosten liegen ebenfalls im zweistelligen Millionenbereich, dazu kommen die hohen Gehälter des extrem spezialisierten Personals, das für den Betrieb nötig ist.

Es ist diese Kombination aus Kosten des ungeheuren Rechenaufwands mit jenen der Messinfrastrukturen und Messkampagnen, die in unzugänglichen oder politisch instabilen Regionen oder gar unter Wasser besonders groß werden können, die die Bilder der Subsurfaces so kostspielig werden lässt.

Inzwischen haben Ölfirmen wie Schlumberger Kooperationen mit Cloudanbietern wie Google geschlossen und betreiben Teile ihrer Subsurfacemodellierung in deren Datencentern. Schlumberger hat seine Subsurfacesuite mit Google-Maps integriert und so können Ingenieure und Ingenieurinnen weltweit über einen Internetanschluss ihren Blick in die Tiefe schicken.

Anders als bei Google Maps ist aber nicht jeder beliebige Punkt der Erde als Bild verfügbar. Subsurfacebilder gibt es nur dort, wo entsprechende Messkampagnen stattgefunden haben. Im Umfeld von existierenden und geplanten Öl- und Gasförderstätten ist das natürlich der Fall, und dort gehen die Bilder der Subsurfaces in die Entscheidungen über Ausbeutung der Felder täglich ein.

Visualisierung der Daten: Die Suche nach Ölvorkommen und möglichen Bohrstrecken unter Umgehung oder Ausnutzung der seismisch erfassten Gesteinsformationen wird bei der Firma Schlumberger an frei navigierbaren 3D-Visualisierungen vorgenommen. Oben: 3D Visualisierung seismischer Daten aus dem Golf von Mexiko. Darunter und rechts: Ölvorkommen in porösen Formationen innerhalb dieses Gebiets, aus: Wyatt Gorman (Google), Abhishek Gupta (Schlumberger): Get Your Head in the Cloud: Lessons in GPU Computing with Schlumberger (Presented by Google Cloud) 2019, S. 45

Wie schaut das Erdinnere aus? Computergenerierte Visualisierungen geben eine erste Vorstellung davon

Das Wissen über das Erdinnere entsteht so zwischen Modi des akustischen Abtastens und der computergenerierten Visualisierung von Oberflächen, die in der historischen Tiefenzeit einmal als tatsächliche Oberflächen am Licht gelegen haben. Immer neue Verfahren der Filterung und Kalibrierung der Daten kommen dabei zur Anwendung. Zugleich stellt der seismografische Datenschatz, den Firmen wie Schlumberger, Baker Hughes, Emerson oder Dassault in ihren Archiven über Jahrzehnte angesammelt haben, einen wesentlichen Teil von deren Kapital dar.

Es sind diese Firmen, die die Karten und Bilder des Untergrunds unablässig verfeinern und horten und permanent mit «postdrill geostatistics», den Messdaten, die an Bohrstelle anfallen, sowie Daten aus laufenden Förderanlagen der Öl- und Gasförderung und dem Fracking abgleichen.

Die Bilder des Untergrunds sind so in eine Feedbackschleife eingebunden, in der Messungen und Bildgebungen fortwährend aufeinander verweisen. Subsurfaces sind damit virtuelle Oberflächen, die zwischen dem Realen der geologischen Formation und dem Virtuellen ihrer digitalen Rekonstruktion auf Bildschirmen entstehen. Was auf ihnen zu sehen ist, stellt im Unterschied zur Fotografie keinen vermeintlich indexikalischen Durchschlag auf einen gewesenen Moment dar, wo das von der Sonne oder einer künstlichen Lichtquelle ausgesandte Licht vom fotografierten Objekt zurückgeworfen wurde und sich in das Negativ oder die Sensoren der Kamera eingeschrieben hat.

Der Status von Bildern der Subsurfaces bleibt letztlich solange zwischen Virtualität und Realität gefangen, bis der seltene Fall einritt, dass ein Bohrkern an die Erdoberfläche geholt wird und die tatsächliche Beschaffenheit der digital rekonstruierten Unteroberfläche bestätigt werden kann. Bohrkerne erlauben den Abgleich zwischen virtueller Rekonstruktion und unterirdischen Begebenheiten. Aber nur für einen kleinen, den Umfang des Bohrlochs entsprechenden Abschnitt. Wie es wenige Meter links oder rechts vom Bohrloch aussieht, kann nur virtuell beleuchtet werden.

Was unter der Erdoberfläche ist, bleibt letztlich rätselhaft

Die Literatur zur seismischen Rekonstruktion von der Subsurfaces merkt immer wieder an, das Ziel dieser Verfahren sei die Minimierung von Unwissenheit. Was unter der Erde ist, bleibt auch mit den heute verfeinerten Verfahren der Bildgebung rätselhaft und die sich auf diese Bilder stützenden Explorationen risikobehaftet.

Die kostspieligen Bilder der Subsurfaces sind Bilder der Unsicherheit. Sie werden erzeugt, um noch höhere Kosten in der Zukunft zu vermeiden. Das Zeitverhältnis der Bilder der Subsurfaces ist damit umgekehrt zu den Oberflächen, die die Fotografie einfängt: Es sind nicht Bilder, welche einen vergangenen Moment in die Gegenwart holen, sondern Bilder möglicher Zukünfte, die sich beim Bohren und Ausbeuten der dargestellten Erdschichten bestätigen könnten.

Obwohl Subsurfaces Jahrtausende und Millionen Jahre alte Formationen zeigen, sind es Bilder von etwas, das sich erst noch ereignen muss.

Christoph Engemann

Christoph Engemann ist Postdoc am Virtual Humanities Lab der Ruhr-Universität Bochum und war im Winter 2020/21 Gastprofessor für Medienwissenschaft an der Zhejiang Universität in Hangzhou, China. Forschung und Lehre zur Geschichte, Theorie und Ästhetik digitaler Medien sowie zu Scheunen und Ländlichkeit. Wissenschaftliche Beratung von Ausstellungsprojekten, zuletzt bei den Ausstellungen «Oil. Schönheit und Schrecken des Erdölzeitalters» am Kunstmuseum Wolfsburg und «Uncanny Valleys - Künstliche Intelligenz und Du» am Museum angewandte Kunst Wien.

Quellen und Verweise

[1] LeMenager, Stephanie. Living Oil: Petroleum Culture in the American Century. New York: Oxford University Press, 2014.

[2] Klose, Alexander und Steininger, Benjamin. Erdöl Ein Atlas Der Petromoderne. Berlin: Matthes & Seitz Berlin, 2021, S. 49f

Mehr ReVue

passieren lassen?

Der ReVue Newsletter erscheint einmal im Monat. Immer dann, wenn ein neuer Artikel online geht. Hier en passant abonnieren.

Sie möchten unsere Arbeit

mit einer Spende unterstützen?

Hier en passant spenden!

Fotografie ist allgegenwärtig, wird aber in den journalistischen Medien noch wenig hinterfragt oder erklärt. Wer an Journalismus denkt, denkt an Texte. Das digitale Magazin ReVue verfolgt einen anderen Ansatz: Es nähert sich den Themen vom Bild her. In unseren Beiträgen untersuchen wir die Rolle und Funktion von Bildern im Verhältnis zum Text, zur Wahrheit, zum politischen oder historischen Kontext. Wie nehmen wir Bilder wahr? Welche Geschichte steckt dahinter?

Unsere Beiträge erscheinen auf Deutsch, wir übersetzen aber auch fremdsprachige Texte und erleichtern so den Wissenstransfer zu einer deutschsprachigen Leserschaft.

ReVue ist unabhängig. Die Redaktion arbeitet ehrenamtlich. ReVue ist ein Projekt der gemeinnützigen DEJAVU Gesellschaft für Fotografie und Wahrnehmung e.V. in Berlin.

Herausgeberin

DEJAVU

Gesellschaft für Fotografie und Wahrnehmung e.V.

Methfesselstrasse 21

10965 Berlin

ReVue ISSN2750–7238

ReVue wird unterstützt von